What is a computer?

Reading time30 minEn bref

Résumé de l’article

Dans cette conférence, nous donnons les définitions de quelques concepts clés en informatique autour des ordinateurs, en commençant par leur définition même, leurs architectures et les différents composants matériels d’un ordinateur moderne.

Principaux points à retenir

- Un ordinateur est un dispositif électronique qui peut être programmé pour exécuter automatiquement des séquences d’opérations arithmétiques ou logiques (calcul).

- L’ordinateur réel repose sur une description d’un système informatique appelée architecture, et les plus courantes sont : les architectures von Neumann et Harvard.

- Un ordinateur est composé de plusieurs composants matériels tels que le CPU, les modules RAM, les dispositifs de stockage connectés via une carte mère.

- L’utilisateur peut interagir avec un ordinateur en utilisant une variété de périphériques.

- Pour utiliser un ordinateur, l’utilisateur a besoin d’un système d’exploitation.

Contenu de l’article

Même si vous avez probablement tous utilisé un ordinateur, écrit ou installé des programmes, ou même construit votre propre machine, il est parfois important de revenir aux bases pour construire une fondation solide en ingénierie.

1 — L’ordinateur

Un ordinateur est un dispositif électronique qui peut être programmé pour exécuter automatiquement des séquences d’opérations arithmétiques ou logiques (calcul). Bien que des machines aient été utilisées pour des tâches arithmétiques dès 2700 av. J.-C. (Abacus, Pascaline, la Analytical Engine de Charles Babbage, etc.), le terme ordinateur a acquis sa définition moderne au milieu du XXe siècle.

Le principe de l’ordinateur moderne a été formulé par Alan Turing en 1936 lorsqu’il a proposé ce que l’on appelle aujourd’hui une machine de Turing universelle capable de calculer tout ce qui est calculable en exécutant des instructions (programme) stockées sur une bande. Pour simplifier à l’extrême, une machine de Turing fonctionne en lisant et écrivant des symboles sur une bande infinie selon un ensemble de règles définies par sa fonction de transition. Elle déplace sa tête de lecture/écriture à gauche ou à droite et change d’état en fonction du symbole et de l’état actuels, ce qui lui permet d’effectuer des calculs complexes.

Ada Lovelace, née en 1815, est souvent considérée comme la première programmeuse informatique au monde. Elle a écrit le premier algorithme destiné à la machine analytique de Charles Babbage, un ordinateur mécanique à usage général. Le travail visionnaire de Lovelace a anticipé le potentiel des ordinateurs à aller au-delà des simples calculs, en envisageant leur capacité à manipuler des symboles et à créer de l’art et de la musique. Ses contributions ont jeté les bases du domaine de l’informatique bien avant le début de l’ère des ordinateurs modernes.

2 — Architectures

La transition du cadre théorique de la machine de Turing à un ordinateur réel repose sur une description d’un système informatique. Un tel système informatique est ce que l’on appelle une architecture informatique.

2.1 — Architecture von Neumann

L’architecture von Neumann (ou architecture de Princeton), nommée d’après le mathématicien John von Neumann, a été proposée en 1945 dans le First Draft of a Report on the EDVAC. Elle s’inspire de l’ENIAC, conçu par J. Presper Eckert et John Mauchly, qui est le premier ordinateur numérique “programmable, électronique et à usage général”.

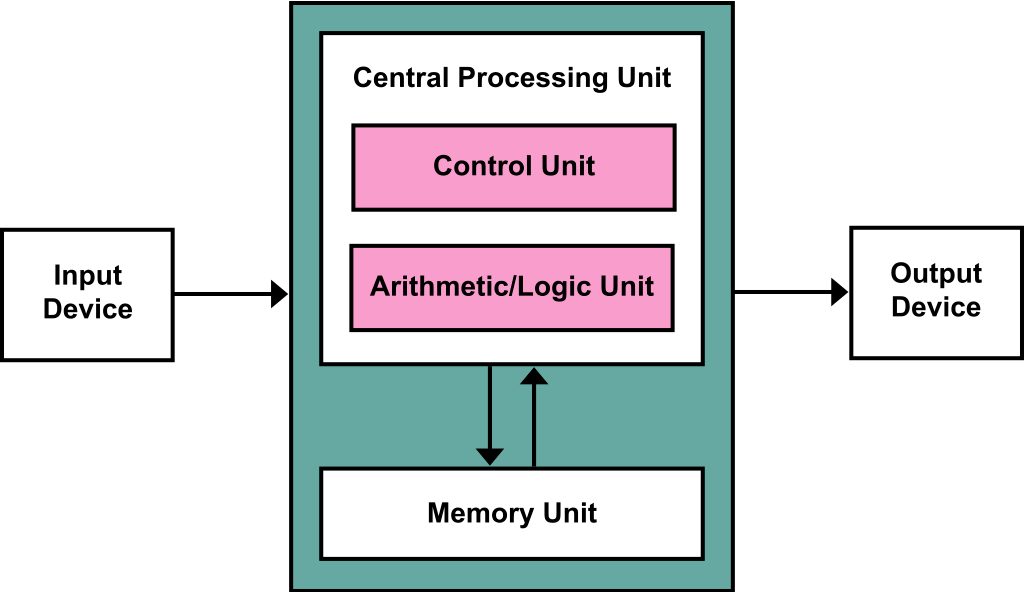

Cette architecture se compose de :

- Une unité centrale de traitement avec à la fois une unité arithmétique et logique (ALU) et des registres processeurs.

- Une unité de contrôle qui inclut un registre d’instruction et un compteur de programme.

- Une mémoire qui stocke les données et les instructions.

- Un stockage de masse externe.

- Des mécanismes d’entrée et de sortie.

La particularité de cette architecture est que les instructions et les données sont stockées dans la même mémoire. En traitant les instructions de la même manière que les données, un ordinateur avec un programme stocké peut facilement modifier les instructions. Une raison importante pour cette capacité était la nécessité pour un programme d’incrémenter ou de modifier le champ d’adresse des instructions (par exemple, pour créer des boucles). Cette raison est devenue moins importante avec l’avènement des registres d’index et de l’adressage indirect comme fonctionnalités standard des processeurs.

L’architecture von Neumann présente un inconvénient majeur appelé le “goulot d’étranglement von Neumann”, qui fait référence au débit limité entre le CPU et la mémoire. Puisque les instructions et les données partagent le même bus, cela peut créer un goulot d’étranglement des performances, surtout à mesure que la vitesse du CPU augmente mais que celle de la mémoire ne suit pas. En raison du bus partagé, l’accès à la mémoire pour les instructions et les données peut également entraîner une latence accrue.

De plus, puisque les instructions et les données sont stockées dans le même espace mémoire, il est plus facile pour les programmes malveillants d’exploiter des vulnérabilités et de modifier les instructions, ce qui entraîne des risques de sécurité tels que les attaques par dépassement de tampon.

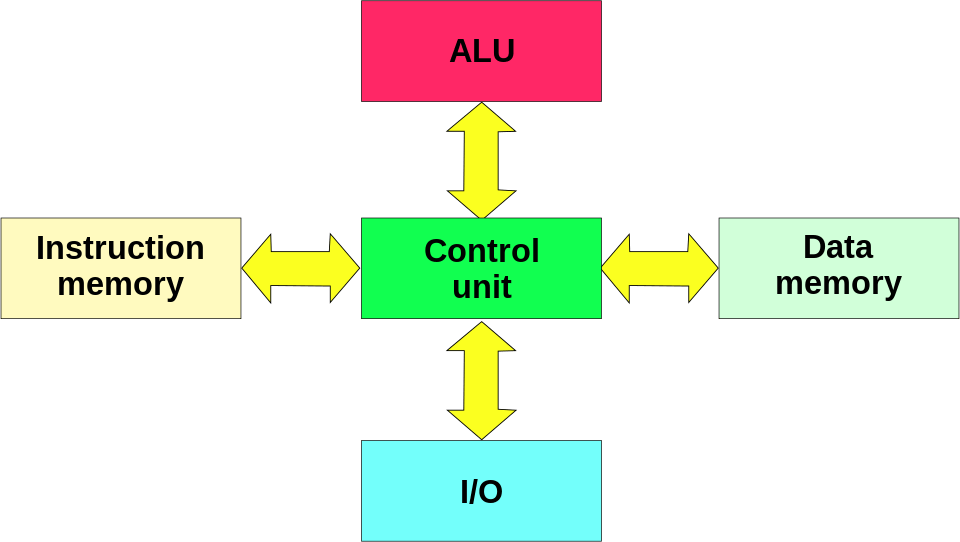

2.2 — Architecture Harvard

Contrairement à l’architecture von Neumann, l’architecture Harvard utilise une mémoire séparée et des voies séparées pour les instructions et les données. Cela signifie que le CPU dispose d’espaces mémoire distincts et de voies distinctes pour les instructions et les données, permettant un accès simultané aux deux. Cette séparation permet un traitement des données plus rapide et plus efficace, car le CPU peut récupérer les instructions et lire/écrire les données en même temps.

Cependant, cette conception a un coût plus élevé, peut réduire la flexibilité et la programmation pour une telle architecture est généralement plus difficile. C’est pourquoi elle est souvent utilisée dans du matériel spécifique, principalement le traitement numérique du signal (DSP) et les microcontrôleurs tels que les Atmel AVR et non dans les ordinateurs à usage général.

Les DSP ont été popularisés par leur inclusion dans de nombreuses cartes de développement open hardware de la gamme Arduino.

Enfin, les ordinateurs et processeurs modernes apparaissent à l’utilisateur comme des systèmes avec des architectures von Neumann, avec le code du programme stocké dans la même mémoire principale que les données. Pour des raisons de performance, en interne et largement invisibles pour l’utilisateur, la plupart des conceptions ont des caches processeurs séparés pour les instructions et les données, avec des voies séparées vers le processeur pour chacun. C’est une forme de ce que l’on appelle l’architecture Harvard modifiée.

3 — Composants matériels

Les architectures décrites dans les sections précédentes restent un peu théoriques, ici nous avons l’intention de présenter les composants matériels réels d’un système informatique.

3.1 — L’unité centrale de traitement (CPU)

Dans l’architecture von Neumann, le CPU est responsable de l’exécution des instructions récupérées de la mémoire.

Voici les composants d’un CPU :

-

Unité de contrôle (CU) – L’unité de contrôle dirige le fonctionnement du processeur. Elle interprète les instructions de la mémoire et les convertit en signaux qui contrôlent les autres parties de l’ordinateur. Elle récupère l’instruction, la décode, puis envoie les signaux nécessaires pour l’exécuter. Son rôle est d’agir comme un gestionnaire de trafic dirigeant le flux de données à l’intérieur du CPU.

-

Unité arithmétique et logique (ALU) – L’ALU effectue toutes les opérations arithmétiques et logiques. Cela inclut l’addition, la soustraction, la multiplication, la division, et les opérations logiques comme AND, OR, NOT, et XOR. Son rôle est d’exécuter les calculs mathématiques et les comparaisons logiques.

-

Registres – Les registres sont de petits emplacements de stockage rapides à l’intérieur du CPU. Ils contiennent des données, des instructions et des adresses utilisées immédiatement par le CPU.

Il existe plusieurs types de registres :

- Les registres de données contiennent des valeurs intermédiaires des opérations arithmétiques et logiques.

- Les registres d’adresse stockent les adresses mémoire utilisées par les instructions.

- Les registres à usage spécial incluent le registre d’instruction (IR), le compteur de programme (PC) et le registre d’état (SR).

-

Cache – Le cache est une mémoire plus petite et plus rapide qui stocke des copies des données provenant des emplacements de mémoire principale fréquemment utilisés. Il accélère la récupération des données en réduisant le temps nécessaire pour accéder à la mémoire.

Il existe plusieurs niveaux de caches.

- Les caches L1 sont petits et extrêmement rapides, situés sur la puce CPU.

- Les caches L2 sont plus grands que les L1, légèrement plus lents, et peuvent être situés sur ou près de la puce CPU.

- Les caches L3 sont encore plus grands et plus lents, partagés entre plusieurs cœurs CPU.

-

Unité d’interface de bus – L’unité d’interface de bus connecte le CPU au bus du système, permettant la communication avec la mémoire et d’autres périphériques. Son rôle est de gérer le transfert de données entre le CPU et les autres composants.

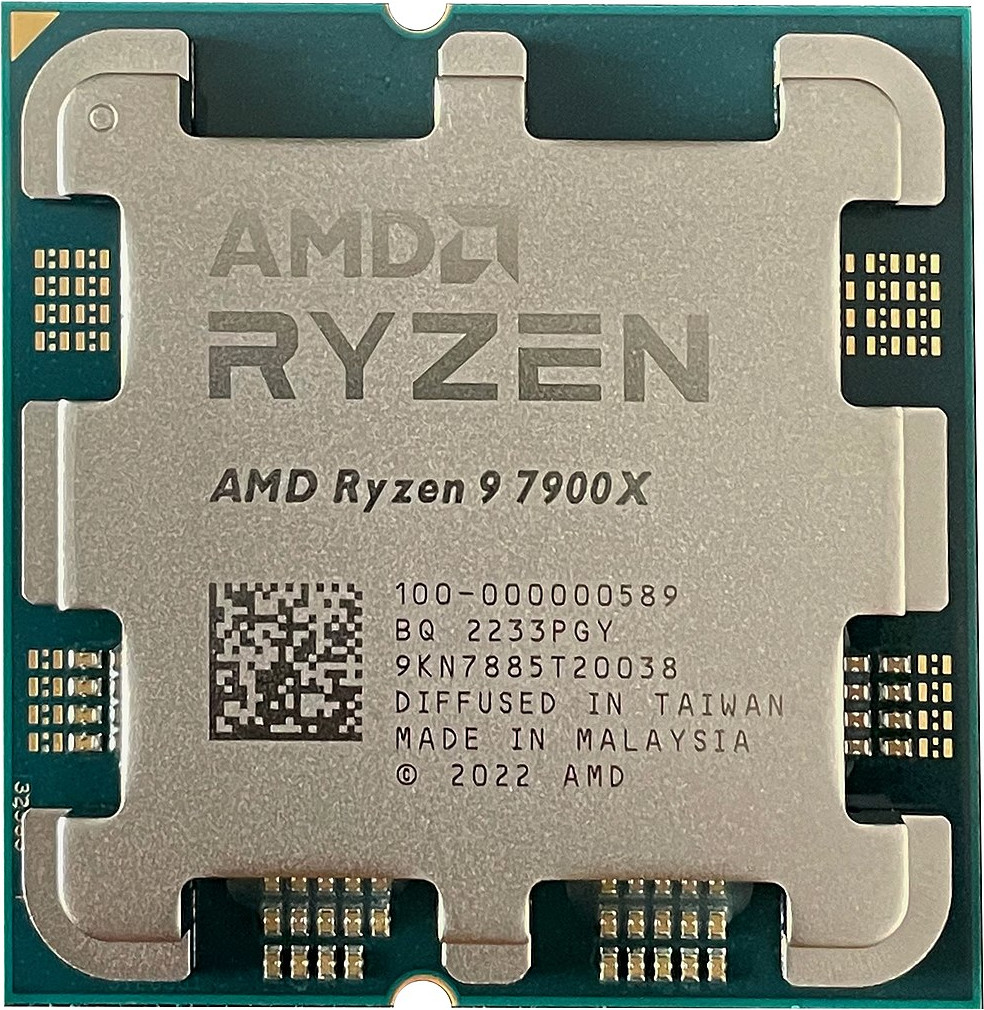

Un processeur multi-cœur est un type d’unité centrale de traitement (CPU) qui possède deux cœurs indépendants ou plus (également appelés unités d’exécution) intégrés dans une seule puce de silicium. Chaque cœur peut lire et exécuter des instructions indépendamment, ce qui permet le traitement parallèle et améliore les performances tant en multitâche que dans les tâches computationnelles complexes.

Les processeurs multi-cœurs offrent des performances améliorées et une meilleure efficacité énergétique grâce au traitement parallèle et aux capacités multitâches accrues. Cependant, ils nécessitent une optimisation logicielle pour exploiter pleinement leur potentiel et peuvent ajouter de la complexité à la programmation, avec des rendements décroissants à mesure que le nombre de cœurs augmente.

Le multithreading est un modèle de programmation et d’exécution qui permet à plusieurs threads de s’exécuter simultanément au sein d’un même processus. Chaque thread représente un chemin d’exécution séparé, permettant d’effectuer des tâches simultanément. Cela est particulièrement bénéfique dans les applications nécessitant un haut niveau de parallélisme, telles que les serveurs web, le traitement de données et les systèmes en temps réel. En divisant un programme en threads plus petits, le multithreading peut considérablement améliorer les performances et la réactivité d’une application. Les systèmes d’exploitation et les CPU modernes fournissent un support intégré pour le multithreading, permettant aux threads d’être planifiés et exécutés efficacement sur plusieurs cœurs.

L’avantage principal du multithreading est l’amélioration des performances des applications, en particulier sur les processeurs multi-cœurs. En permettant l’exécution parallèle des tâches, le multithreading peut réduire le temps nécessaire pour accomplir des opérations complexes, conduisant à des programmes plus rapides et plus efficaces. Cela est particulièrement important pour les applications qui effectuent des opérations d’entrée/sortie, car les threads peuvent gérer plusieurs requêtes d’E/S simultanément, réduisant la latence et augmentant le débit. De plus, le multithreading améliore la réactivité des applications, car les tâches d’interface utilisateur peuvent s’exécuter dans des threads séparés, permettant à l’application de rester interactive tout en effectuant des opérations en arrière-plan. Cependant, le multithreading introduit également plusieurs défis et inconvénients potentiels. Un problème majeur est la complexité d’écrire du code thread-safe. Les développeurs doivent gérer soigneusement les ressources partagées et assurer une synchronisation appropriée pour éviter les conditions de concurrence, les interblocages et autres bugs liés à la concurrence.

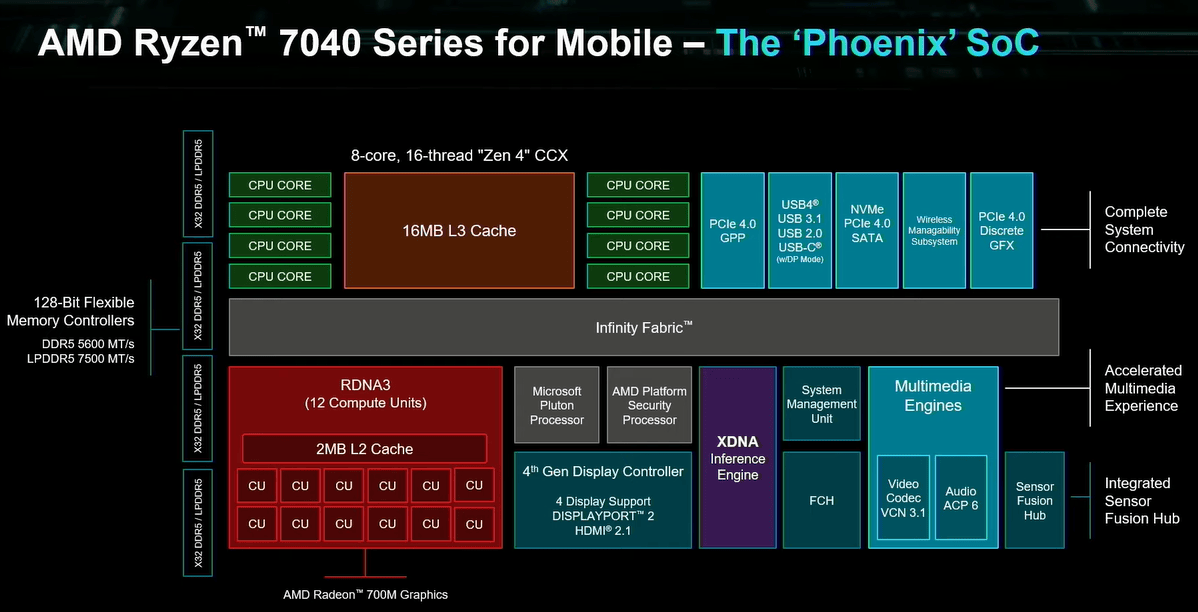

Processeur mobile AMD Ryzen 7040 Series (source).

En pratique, les CPU modernes à usage général sont définis par d’autres spécifications listées ci-dessous :

-

Architecture – CISC (Complex Instruction Set Computing), RISC (Reduced Instruction Set Computing), etc. (ex. x86, x86-64, ARM, RISC-V).

-

Jeu d’instructions – L’ensemble des instructions que le CPU peut exécuter, incluant souvent des extensions pour des améliorations spécifiques de performance (ex. x86-64, AVX, SSE).

-

Fréquence de base – La fréquence à laquelle le CPU fonctionne dans des conditions standard, mesurée en GHz (gigahertz) (ex. 3.5 GHz, 3.8 GHz).

-

Nombre de cœurs – Le nombre de cœurs physiques dans le CPU (ex. Dual-core, Quad-core, Octa-core).

-

Nombre de threads – Le nombre de threads concurrents que le CPU peut gérer, souvent influencé par des technologies comme Hyper-Threading (Intel) ou Simultaneous Multithreading (SMT) (AMD) (ex. 8 threads, 16 threads).

-

Technologie de fabrication – Le procédé de fabrication utilisé pour produire le CPU, généralement mesuré en nanomètres (nm) (ex. 14nm, 7nm, 5nm, 3nm).

-

TDP (Thermal Design Power) – La quantité de chaleur que le CPU est censé dissiper sous charge maximale, mesurée en watts (W) (ex. 65W, 95W, 125W).

-

Fonctionnalités et technologies – Capacités et technologies supplémentaires supportées par le CPU (ex. Hyper-Threading, Turbo Boost, Virtualization (VT-x/AMD-V), AES-NI).

3.2 — La mémoire (RAM)

L’architecture von Neumann stipule un espace mémoire unique qui contient à la fois les données et les instructions du programme. La RAM (Random Access Memory) est un composant crucial dans les ordinateurs modernes et les dispositifs électroniques. Elle sert de mémoire volatile principale où les données et instructions sont temporairement stockées pendant que l’ordinateur est allumé et en fonctionnement.

3.2.1 — Caractéristiques

-

Nature volatile – La RAM est volatile, ce qui signifie qu’elle perd ses données stockées lorsque l’ordinateur est éteint. Cette caractéristique contraste avec les dispositifs de stockage non volatils comme les disques durs et les SSD, qui conservent les données même lorsque l’alimentation est coupée.

-

Vitesse d’accès rapide – La RAM est conçue pour un accès rapide aux données. Elle fonctionne à des vitesses bien supérieures à celles des dispositifs de stockage typiques comme les disques durs ou les SSD. Cette vitesse d’accès rapide est cruciale pour le bon fonctionnement fluide des applications et la réactivité globale de l’ordinateur.

-

Stockage temporaire – La RAM sert de stockage temporaire pour les données et instructions du programme que le CPU doit accéder rapidement. Lorsque vous ouvrez un programme ou un fichier, le système d’exploitation le charge dans la RAM afin que le CPU puisse accéder rapidement aux données nécessaires sans attendre les dispositifs de stockage plus lents.

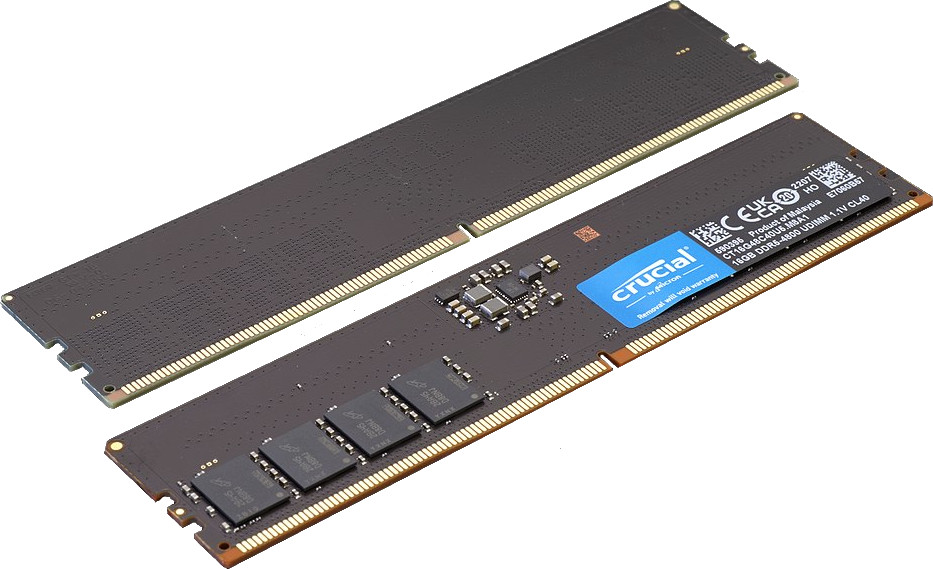

3.2.2 — Composants et architecture

Les modules RAM sont généralement intégrés dans la carte mère d’un ordinateur et existent sous différentes formes, telles que les DIMM (Dual Inline Memory Modules) ou SO-DIMM (Small Outline DIMMs) pour les ordinateurs portables et les dispositifs plus petits.

L’architecture des modules RAM comprend :

-

Cellules mémoire – Ce sont les plus petites unités de stockage dans la RAM, généralement organisées en grille. Chaque cellule stocke un chiffre binaire (bit), et des groupes de cellules stockent des octets (8 bits) de données.

-

Adressage – La RAM est adressée à l’aide d’une adresse mémoire, qui spécifie l’emplacement de chaque octet de données. Les ordinateurs modernes utilisent un système d’adressage binaire pour localiser rapidement des emplacements mémoire spécifiques.

-

Capacité – La capacité de la RAM est mesurée en gigaoctets (GB) ou téraoctets (TB). La quantité de RAM dans un ordinateur détermine la quantité de données qu’il peut stocker et accéder simultanément.

16 GB DDR5-4800 1.1 V UDIMM (source).

3.3 — Dispositifs de stockage (HDD/SSD)

Les dispositifs de stockage sont des composants matériels utilisés pour stocker et récupérer des données numériques. Contrairement à la RAM, ils fournissent un stockage persistant, ce qui signifie que les données restent stockées même lorsque l’ordinateur est éteint. Cela est crucial pour sauvegarder les programmes, documents, états système et autres données importantes. Ils existent sous différentes formes et capacités, conçus pour répondre à différents besoins en termes de vitesse, capacité et durabilité.

Voici les principaux types de dispositifs de stockage :

-

Disques durs (HDD) – Les HDD sont des dispositifs de stockage traditionnels qui utilisent des disques magnétiques tournants pour lire et écrire des données. Ils sont connus pour leurs grandes capacités de stockage et leur coût relativement faible par gigaoctet. Ils ont l’avantage d’avoir une grande capacité, un coût efficace et une longue durée de vie. Cependant, ils présentent des inconvénients tels que des vitesses de lecture/écriture plus lentes comparées aux disques à état solide, et des pièces mécaniques sujettes à des pannes.

-

Disques à état solide (SSD) – Les SSD utilisent la mémoire flash pour stocker les données, offrant des vitesses de lecture/écriture plus rapides que les HDD. Ils n’ont pas de pièces mobiles, ce qui les rend plus durables et moins sujets aux pannes mécaniques. Ils ont l’avantage d’offrir de meilleures performances, une plus grande durabilité et une meilleure efficacité énergétique. Cependant, ils ont des inconvénients tels qu’un coût plus élevé par gigaoctet et un nombre limité de cycles d’écriture.

Trois types de dispositifs de stockage de gauche à droite : un disque dur 2,5’’ (source), un SSD 2,5’’ (source) et un SSD NVME (source)

3.4 — Carte mère

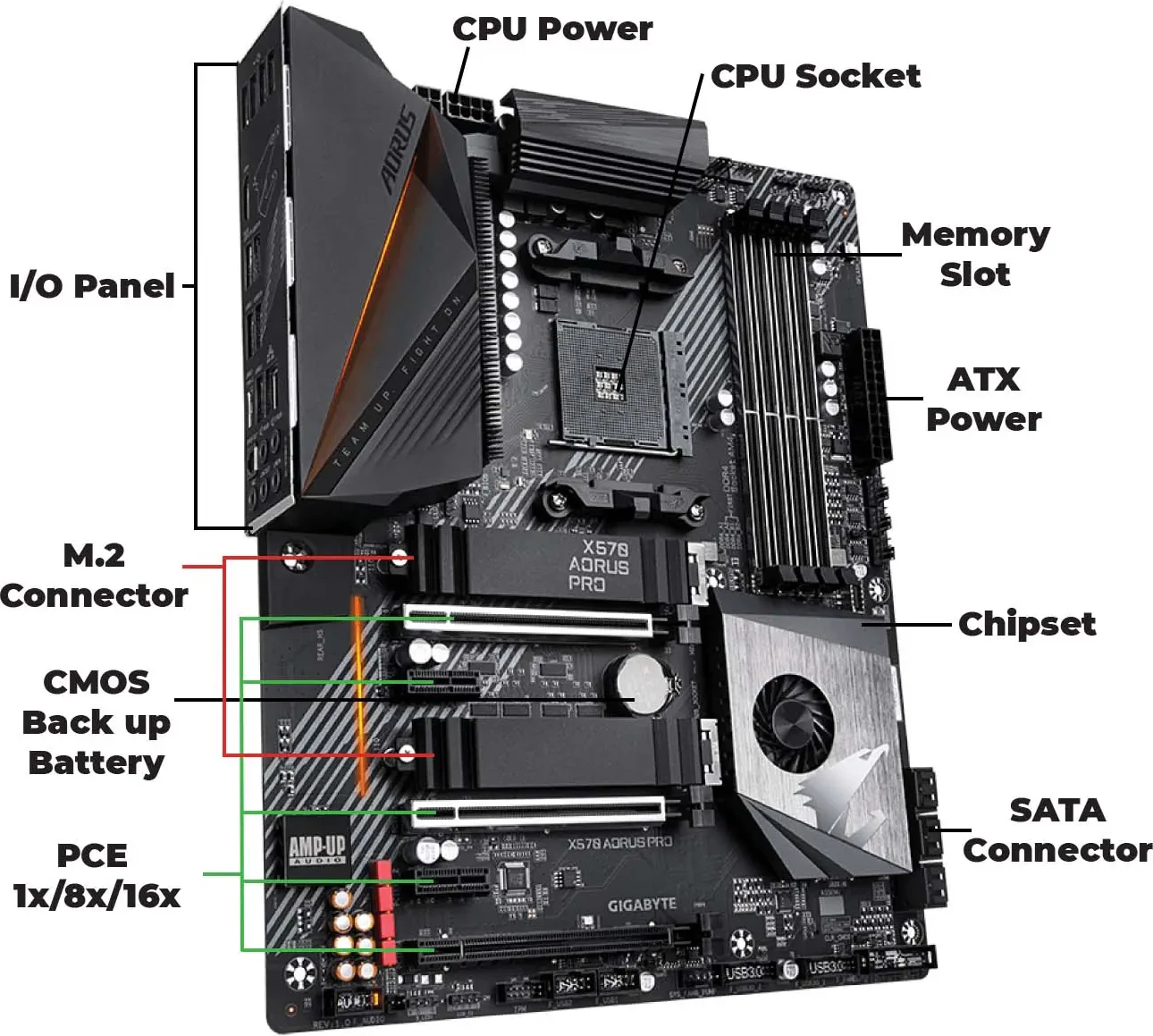

La carte mère, également appelée carte principale ou carte système, est le circuit imprimé principal dans un ordinateur. Elle sert de hub central qui héberge le CPU, la mémoire et d’autres composants essentiels. La carte mère fournit également des connecteurs pour d’autres périphériques et cartes d’extension.

Voici les composants clés et les caractéristiques d’une carte mère :

-

Socket CPU – Le slot où le processeur central (CPU) est installé. Différents CPU nécessitent différents sockets, spécifiques à certains modèles de cartes mères.

-

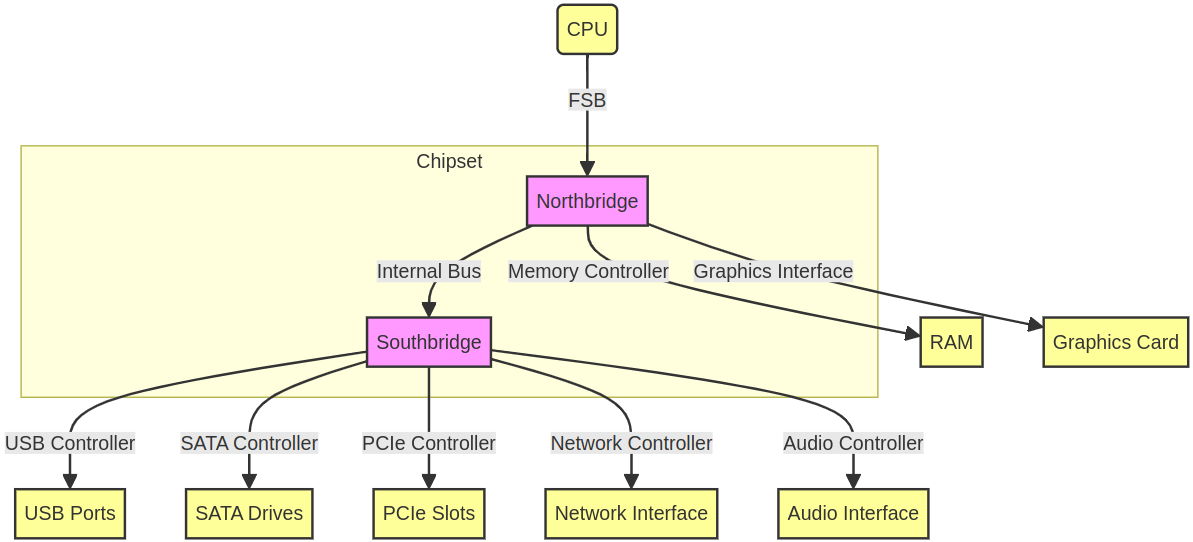

Chipset – Un ensemble de circuits intégrés qui gèrent le flux de données entre le processeur, la mémoire et les périphériques. Le chipset est divisé en deux composants principaux : le Northbridge (gère la communication à haute vitesse entre le CPU, la RAM et la carte graphique) et le Southbridge (gère les bus périphériques à basse vitesse tels que USB, audio et disques durs).

Vue schématique d’un chipset.

Les CPU modernes intègrent généralement des fonctionnalités qui faisaient traditionnellement partie du Northbridge directement sur la puce CPU elle-même. Cette intégration est connue sous le nom de conception “System-on-Chip” (SoC). Globalement, l’intégration de ces fonctionnalités sur la puce CPU a conduit à une conception de système plus efficace et compacte, ce qui simplifie les conceptions de cartes mères et réduit la consommation d’énergie tout en améliorant les performances globales du système.

-

Slots RAM (slots DIMM) – Emplacements où les modules de mémoire RAM de l’ordinateur sont installés. Le nombre et le type de slots RAM peuvent varier selon la conception de la carte mère.

-

Connecteurs de stockage – Interfaces pour connecter des dispositifs de stockage comme les disques durs (HDD) et les disques à état solide (SSD). Les types courants incluent les ports SATA et les slots M.2 pour les SSD plus récents.

-

Slots d’extension – Emplacements pour des cartes additionnelles telles que les cartes graphiques, cartes son, cartes réseau et autres cartes d’extension. Le type le plus courant est le slot PCIe (Peripheral Component Interconnect Express).

-

Connecteurs d’alimentation – Connecteurs qui fournissent l’alimentation de l’alimentation électrique à la carte mère et aux autres composants. Cela inclut le connecteur d’alimentation principal ATX 24 broches et des connecteurs supplémentaires 4 ou 8 broches pour le CPU.

-

Ports E/S – Le panneau arrière de la carte mère contient des ports d’entrée/sortie pour connecter des périphériques comme le clavier, la souris, le moniteur, les dispositifs USB, les dispositifs audio et les câbles réseau.

-

Puces BIOS/UEFI – Une interface firmware qui initialise le matériel lors du processus de démarrage et fournit des services d’exécution pour les systèmes d’exploitation et les programmes. Le BIOS (Basic Input/Output System) ou UEFI (Unified Extensible Firmware Interface) est stocké sur une mémoire non volatile sur la carte mère.

-

Dissipateurs thermiques et solutions de refroidissement – Composants qui aident à dissiper la chaleur des parties critiques de la carte mère, telles que le chipset et les VRM (Voltage Regulator Modules).

-

Connecteurs et headers – Divers connecteurs pour des ventilateurs supplémentaires, les boutons du panneau avant (alimentation, reset), les LED et les ports USB.

Voici une photo d’une carte mère, montrant certains des éléments décrits ci-dessus :

Carte mère X570 AORUS PRO ATX (adapté de source).

3.5 — Périphériques

Comme montré ci-dessus, la carte mère inclut divers ports, slots et connecteurs qui ont été brièvement décrits. Dans cette section, nous allons entrer un peu plus dans les détails sur certains des périphériques les plus utilisés et leurs connecteurs les plus courants.

3.5.1 — Entrée/Sortie

Historiquement, il y avait beaucoup de connecteurs I/O spécifiques pour différents périphériques. Par exemple, les ports PS/2 utilisés pour connecter les claviers et souris à un système compatible PC ou les ports série qui ont été largement remplacés par des standards plus rapides, principalement USB (voir ci-dessous). Néanmoins, les ports série restent couramment utilisés dans des applications nécessitant des interfaces simples et à basse vitesse, telles que les systèmes d’automatisation industrielle, les instruments scientifiques, les systèmes de point de vente et certains produits industriels et grand public. Enfin, on peut mentionner que la plupart des ordinateurs modernes incluent ce que l’on appelle une carte son (souvent intégrée directement sur la carte mère). Cela signifie qu’elle fournit des connecteurs I/O pour des périphériques audio analogiques et/ou numériques tels que des haut-parleurs ou des microphones.

De nos jours, la plupart des ports I/O, à l’exception des ports d’affichage (voir section suivante) et des ports réseau, sont des ports USB. L’USB, ou Universal Serial Bus, est une technologie standardisée pour connecter des périphériques à un ordinateur. Elle a été conçue pour simplifier le processus de connexion du matériel à un ordinateur en fournissant une interface universelle et en éliminant le besoin de multiples types de connecteurs et ports.

Voici les principales caractéristiques de l’USB :

-

Compatibilité universelle – L’USB a été créé pour remplacer divers types de ports série et parallèle, offrant un connecteur standard qui fonctionne sur différents dispositifs et plateformes.

-

Plug and play – Les dispositifs USB peuvent être connectés et déconnectés sans avoir besoin de redémarrer l’ordinateur. Le système d’exploitation détecte et configure automatiquement le nouveau dispositif.

-

Hot swappable – Les dispositifs peuvent être connectés ou déconnectés sans éteindre le système.

-

Transfert de données et alimentation – L’USB fournit à la fois des capacités de transfert de données et une alimentation électrique aux dispositifs connectés, ce qui signifie que les périphériques peuvent être alimentés directement via la connexion USB.

-

Débits de transfert élevés – Les standards USB ont évolué pour supporter des débits de transfert plus élevés, les rendant adaptés à une large gamme d’applications allant des claviers simples aux dispositifs de stockage externes à haute vitesse.

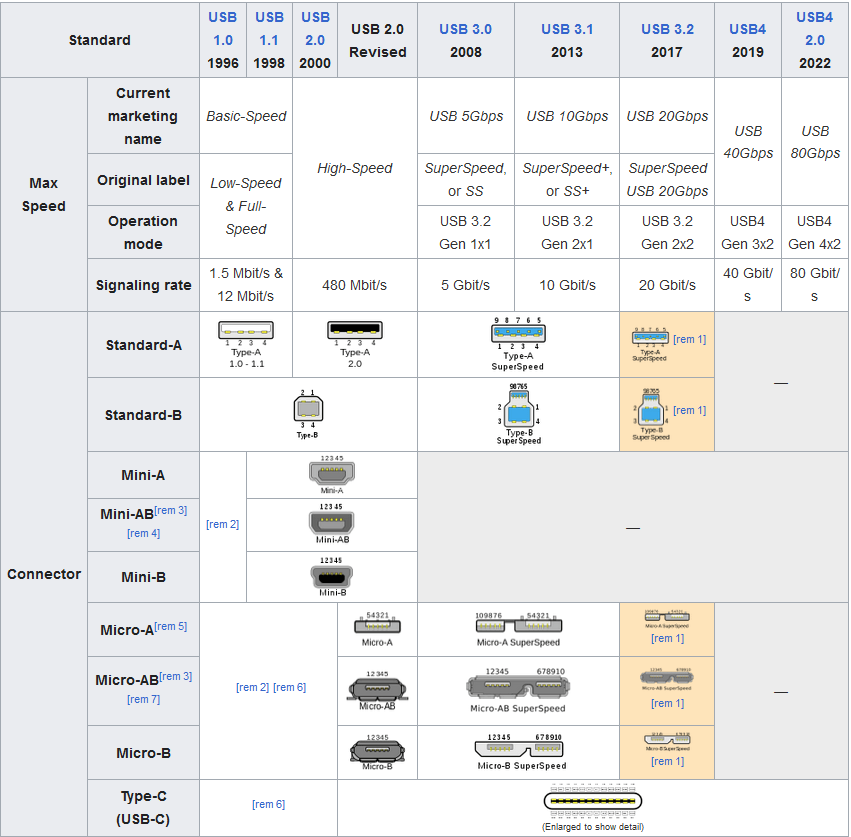

Les standards USB ont évolué avec le temps, comme on peut le voir dans l’image suivante :

Évolution des standards USB (source).

3.5.2 — Affichage

Les périphériques d’affichage pour un PC incluent une variété de dispositifs qui affichent des informations visuelles à l’utilisateur. Le périphérique d’affichage le plus courant est le moniteur, qui peut varier en taille, résolution et technologie. Les moniteurs modernes utilisent souvent la technologie LCD ou LED, offrant une résolution haute définition voire 4K pour des images nettes et claires. D’autres périphériques d’affichage incluent les projecteurs, utilisés pour projeter des images ou des vidéos sur une surface plus grande, et les casques VR, qui offrent des expériences 3D immersives. De plus, certains PC peuvent utiliser des écrans secondaires comme la signalisation numérique ou des écrans spécialisés pour des applications spécifiques, telles que l’imagerie médicale ou la conception graphique professionnelle. La figure ci-dessous donne un bon aperçu de tous les standards qui ont été utilisés et sont encore utilisés aujourd’hui pour afficher une image sur un moniteur, des dispositifs analogiques aux dispositifs numériques.

Comparaison de multiples standards d’affichage (source).

Ces périphériques sont connectés au PC via diverses interfaces, incluant mais sans s’y limiter, HDMI (High-Definition Multimedia Interface, 2002), DisplayPort (2006), DVI (Digital Visual Interface, 1999), ou VGA (Video Graphics Array, 1987).

HIS 6670 iSilence 5 1GB DDR3 PCI-E DVI/HDMI/VGA (source).

4 — Conclusion

Dans ce cours, nous avons donné un bon aperçu de ce qu’est un ordinateur moderne, depuis sa conception fondamentale, ses architectures concrètes jusqu’aux composants physiques qui le composent. Nous avons également décrit certains des périphériques les plus utilisés qui permettent à l’utilisateur d’interagir avec une telle machine. Nous n’avons évidemment pas couvert tous les périphériques, car ils vont des dispositifs grand public tels que souris, claviers, casques audio à des dispositifs plus spécialisés tels que les dispositifs de suivi oculaire, les transducteurs ultrasoniques ou les microscopes numériques par exemple.

Il est également important de souligner que nous avons décrit uniquement les composants physiques des ordinateurs à usage général tels que les ordinateurs personnels. Mais il existe beaucoup plus de facteurs de forme informatique pour des usages très spécifiques allant de votre smartphone typique, consoles de jeux vidéo, dispositifs IoT (Internet des objets), cartes à puce, et même certains périphériques eux-mêmes tels que les souris de jeu ou les casques à réduction de bruit.

Bien qu’il soit théoriquement possible d’utiliser ces ordinateurs en envoyant des instructions binaires directement au CPU, cela serait très difficile à utiliser. Pour nous aider dans cette tâche, un logiciel principal appelé système d’exploitation (OS) agit comme un intermédiaire entre les utilisateurs et le matériel informatique, fournissant une interface utilisateur et coordonnant l’exécution des applications.

Pour aller plus loin

Il semble que cette section soit vide !

Y a-t-il quelque chose que vous auriez aimé voir ici ? Faites-le nous savoir sur le serveur Discord ! Peut-être pouvons-nous l’ajouter rapidement. Sinon, cela nous aidera à améliorer le cours pour l’année prochaine !

Pour aller au-delà

Il semble que cette section soit vide !

Y a-t-il quelque chose que vous auriez aimé voir ici ? Faites-le nous savoir sur le serveur Discord ! Peut-être pouvons-nous l’ajouter rapidement. Sinon, cela nous aidera à améliorer le cours pour l’année prochaine !